arm

钉钉

JUC

EPICS

关联数组

大端

adb

数字图像处理

XAML

web课程设计

buildroot

游戏美术

Cadence Allegro

optee

verilog

因数平方和

PyQt5

刷盘

空间关系

电子宠物

权重衰减

2024/4/11 20:23:03【动手学深度学习】权重衰减(含Pytorch从零开始实现的源代码)

目录:权重衰减一、理论知识二、高维线性回归的实现步骤2.1 准备数据2.2 初始化模型参数2.3 定义L2L_2L2范数惩罚2.4 定义训练代码实现2.5 是否加入正则化2.5.1 忽略正则化2.5.2 加入正则化三、简单实现四、源代码一、理论知识

前面我们已经介绍学习了过拟合的问题…

机器学习笔记之正则化(二)权重衰减角度(直观现象)

机器学习笔记之正则化——权重衰减角度[直观现象]引言回顾:拉格朗日乘数法角度观察正则化过拟合的原因:模型参数的不确定性正则化约束权重的取值范围L1L_1L1正则化稀疏权重特征的过程权重衰减角度观察正则化场景构建权重衰减的描述过程权重衰减与过拟合…

权重衰减(weight decay)

L2 正则化的目的就是为了让权重衰减到更小的值,在一定程度上减少模型过拟合的问题,所以权重衰减也叫 L2 正则化。

参考:

https://blog.csdn.net/weixin_44936889/article/details/103705435https://microstrong.blog.csdn.net/article/deta…

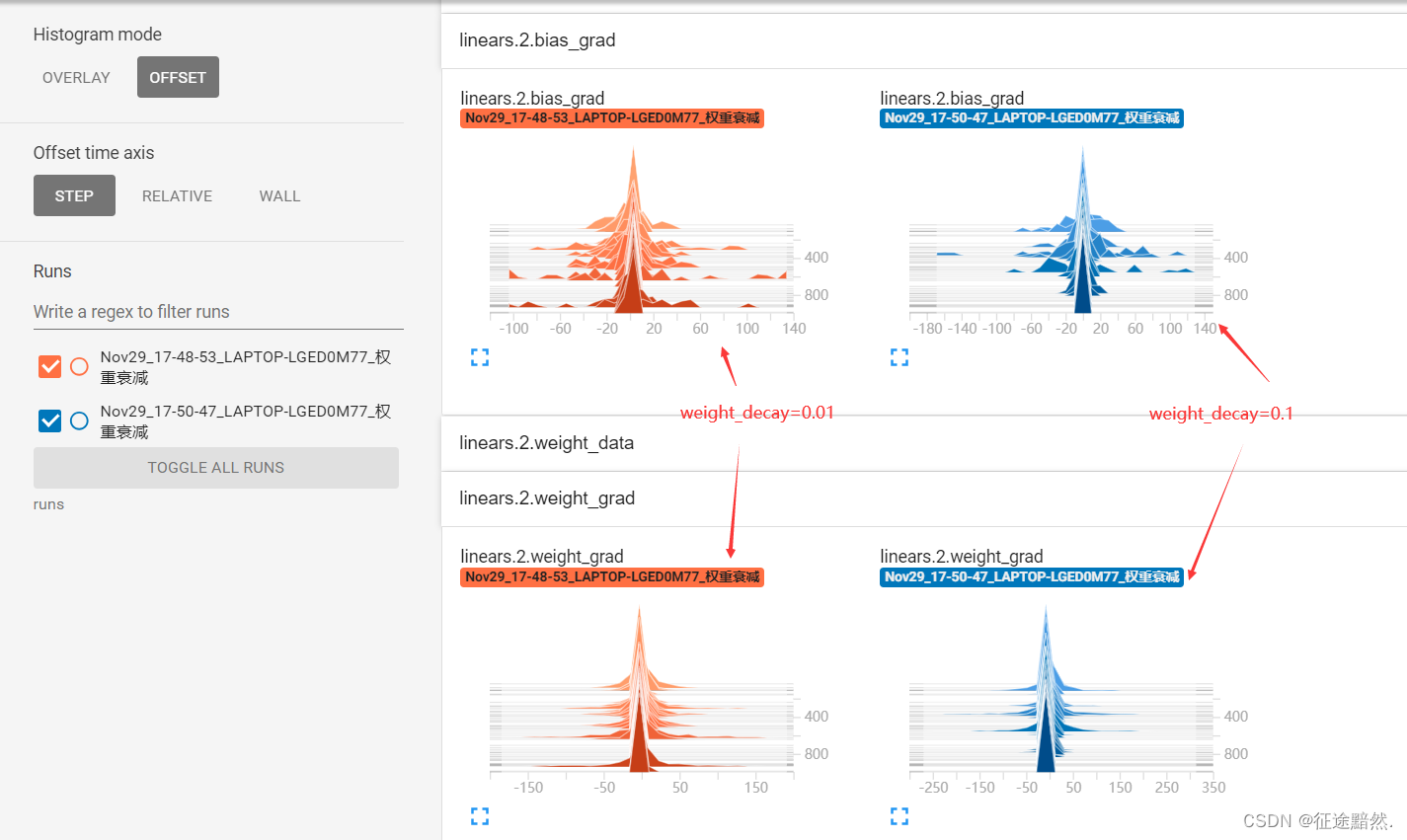

优化器原理——权重衰减(weight_decay)

优化器原理——权重衰减(weight_decay) weight_decay的作用 原理解析 实验观察 在深度学习中,优化器的 weight_decay 参数扮演着至关重要的角色。它主要用于实现正则化,以防止模型过拟合。过拟合是指模型在训练数据上表现优异&…